Il 13 luglio 2024, dopo settimane di trattative, le Organizzazioni Sindacali e il Gruppo Bper hanno sottoscritto.

E’ stata attivata la procedura per potere consentire l’accesso al Fondo di Solidarietà in modo volontario a 615 dipendenti con finestra pensionistica fino all’1 gennaio 203 le cui domande non erano state accolte a seguito della manovra aziendale dello scorso 23 dicembre, finalizzata a dimensionare gli organici all’interno del piano industriale 2022-2025 Be-Evolution.

E’ stato concordato un tasso di ricambio generazionale del 75%: saranno assunti 460 nuovi colleghi e saranno rimpiazzati i giovani che si dimetteranno, elevando ulteriormente il tasso di ricambio, tra i più alti del settore.

Il segretario nazionale Uilca Giuseppe Bilanzuoli dichiara: “Siamo molto soddisfatti per l’accordo raggiunto, soprattutto in termini occupazionali e per le assunzioni concordate. L’accordo, raggiunto grazie alle proficue relazioni sindacali nel Gruppo Bper e a un dialogo costante tra le parti, conferma come l’accesso volontario al Fondo di Solidarietà sia uno strumento indispensabile per favorire soluzioni condivise per creare nuova e stabile occupazione di qualità e ricambi di personale per le aziende”.

“Questo buon sistema di relazioni industriali, attraverso la contrattazione continua, consentirà il prossimo ottobre di gestire al meglio le ricadute sul personale del nuovo piano industriale a firma dell’amministratore delegato Gianni Franco Papa. La tenuta dei livelli occupazionali, nel Gruppo come nel settore, sarà sempre un punto centrale”, conclude Bilanzuoli.

Per il segretario responsabile di Gruppo Paolo Tassi c’è grande soddisfazione anche “per il premio aziendale di Bper Banca che verrà erogato nel 2025: è tra i più alti del settore. Si tratta di un valore medio di 1850 euro, composto da una quota in denaro di 1400 euro, che aumenta del 17% per chi li destinasse come welfare, e da una quota in welfare di 450 euro. L’intesa, oltre a soddisfare le richieste di accesso al Fondo di Solidarietà delle colleghe e dei colleghi, conquista nuova e buona occupazione. Ora sarà indispensabile continuare a individuare nuovi percorsi per conseguire il riconoscimento delle professionalità nel Gruppo, valorizzando i giovani e individuando tutele in loro favore, e concentrarsi sulle condizioni del welfare, fondamentale strumento di sostegno per la persona.”

Secondo Rino Tramuto, segretario del coordinamento nazionale Uilca in BPER, “gli accordi sono In linea con la posizione della UILCA e della UIL e tenendo conto delle previsioni e delle opportunità contemplate nel CCNL Credito siglato il 23 novembre 2023; auspichiamo e, ovviamente, vigileremo che la Sicilia ed il Sud possano essere destinatari di parte delle assunzioni di personale. La Sicilia ed il Sud hanno bisogno di buona e nuova occupazione e BPER potrà trarre soltanto benefici da un ricambio generazionale anche nel nostro territorio.”

In un’altra sezione ospitata in un altro edificio con ingresso dalla corte alta, sono presenti opere di varia natura, in genere contemporanee, espressioni delle arti fotografiche e pittoriche, sculture e installazioni.

In un’altra sezione ospitata in un altro edificio con ingresso dalla corte alta, sono presenti opere di varia natura, in genere contemporanee, espressioni delle arti fotografiche e pittoriche, sculture e installazioni.

Dal 1990, nel giardino della villa, sono conservate le spoglie di Renato Guttuso dentro un’arca monumentale realizzata dall’amico scultore Giacomo Manzù.

Dal 1990, nel giardino della villa, sono conservate le spoglie di Renato Guttuso dentro un’arca monumentale realizzata dall’amico scultore Giacomo Manzù.

La sede palermitana della banca è sita in viale Lazio, 9 e si affaccia sulla strada con 7 vetrine. Con questa filiale la banca raggiunge quota 22 sportelli con 102 dipendenti.

La sede palermitana della banca è sita in viale Lazio, 9 e si affaccia sulla strada con 7 vetrine. Con questa filiale la banca raggiunge quota 22 sportelli con 102 dipendenti.

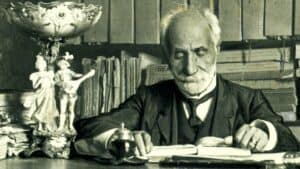

Visita il museo e immergiti “…nella storia che i dotti non hanno scritta, ma che il popolo ha lasciato nei suoi costumi, nelle sue usanze, nelle sue credenze, nei suoi riti”. (G. Pitrè)

Visita il museo e immergiti “…nella storia che i dotti non hanno scritta, ma che il popolo ha lasciato nei suoi costumi, nelle sue usanze, nelle sue credenze, nei suoi riti”. (G. Pitrè)